現(xiàn)在,,AI繪畫完全可以做到指哪打哪了,!

這邊哈士奇,,那邊牧羊犬,,背景在下雪天,。

啪嘰,!一幅畫就這么完成了,。

這個(gè)最新MultiDiffusion模型,,不管選的區(qū)域位置有多離譜,,它都能給你畫出指定的東西來。

比如,,你能看到大象和奶牛同時(shí)握草,??

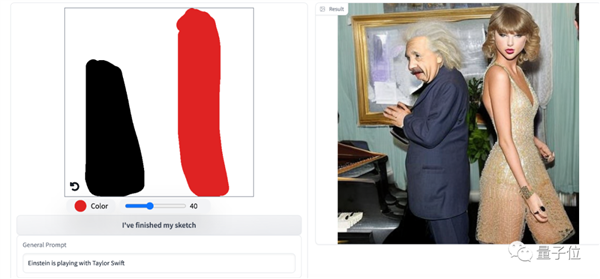

而且在線可試,,親測大概15秒就能出,你甚至可以看到泰勒與愛因斯坦跨時(shí)空同框,。

要知道以前AI繪畫最大的一個(gè)bug就是不可控,但現(xiàn)在人類擁有了更多的控制權(quán),。

總之就是,,想畫什么就畫什么,,想往哪畫就往哪畫!

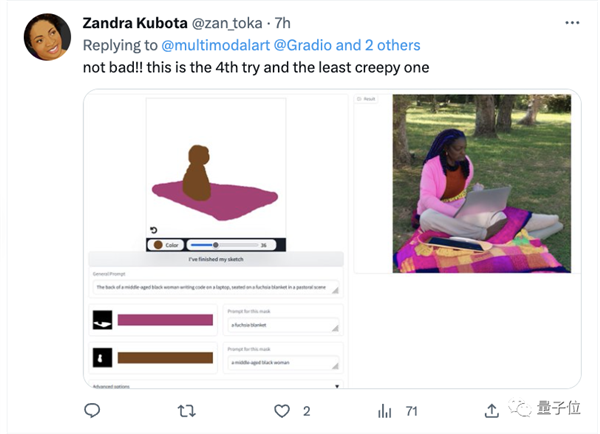

有網(wǎng)友趕緊上手試了試:Not Bad,!

想往哪畫就往哪畫

從效果來看,主要有三個(gè)方面的應(yīng)用,。

文本到高分辨率全景生成,;

精確區(qū)域生成;

任意長寬比粗略區(qū)域生成,。

首先,,只需要一句話,就可以生成512*4609分辨率的全景圖,。

一張有滑雪者的雪山頂峰的照片,。

攝影師也不用爬樓了,,直接獲得城市夜景圖,。

當(dāng)然更為主體功能,,那就是給特定區(qū)域單獨(dú)提示,,然后AI繪畫就來指哪畫哪。

比如在黑色部分是一個(gè)明亮的盥洗室,,紅色區(qū)域是一面鏡子,、藍(lán)色部分是花瓶、黃色部分是白色的水槽,。

就這么隨手一個(gè)拼圖畫,結(jié)果就生成了真實(shí)場景,。

不過也有一些bug,像一些超現(xiàn)實(shí)的,,他就有點(diǎn)太天馬行空了,。

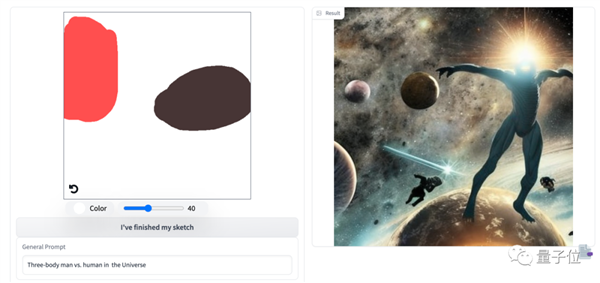

比如三體人在宇宙中大戰(zhàn)人類。

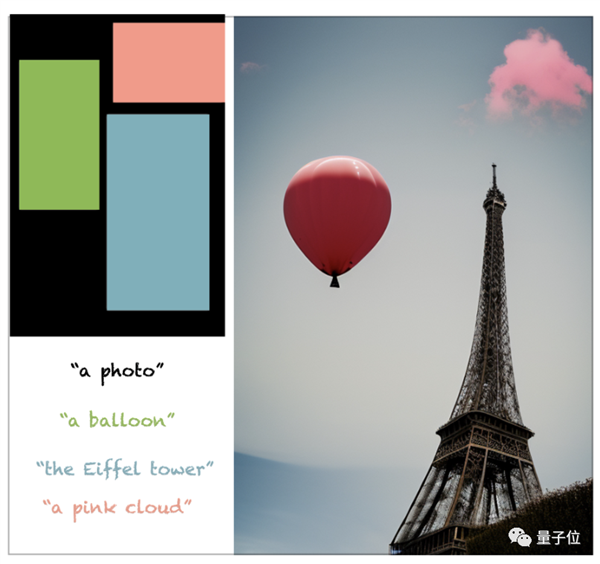

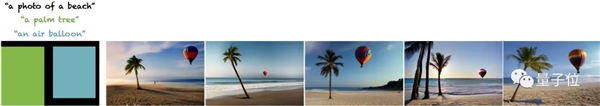

當(dāng)然也可以無需那么精確,,只需標(biāo)個(gè)大致位置,還支持任意長寬比的圖像,。

藍(lán)色部分是埃菲爾鐵塔、紅色是粉色的云,、綠色是熱氣球 ,。

關(guān)鍵是各種構(gòu)圖都十分地合理、場景效果以及實(shí)際物體相對(duì)大小也都十分精準(zhǔn),。

圖像生成可控

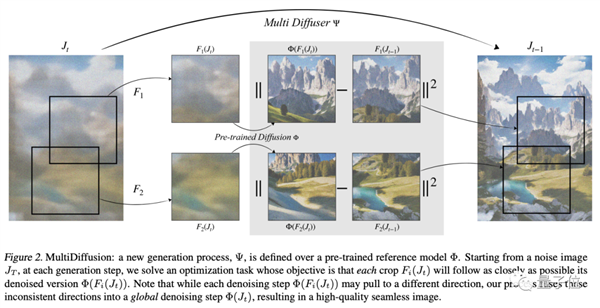

背后的這個(gè)模型叫做MultiDiffusion,,這是一個(gè)統(tǒng)一的框架,能實(shí)現(xiàn)多功能和可控的圖像生成,。

以往即便Diffusion模型給圖像生成帶來變革性影響,,但用戶對(duì)生成圖像的可控性、以對(duì)新任務(wù)的快速適應(yīng)仍是不小的挑戰(zhàn),。

研究人員主要是通過重新訓(xùn)練,、微調(diào),或者另外開發(fā)工具等方式來解決,。前不久爆火插件ControlNet正是解決了圖像生成的可控性,,

而MultiDiffusion無需進(jìn)一步訓(xùn)練或微調(diào),就可一次實(shí)現(xiàn)對(duì)生成內(nèi)容的多種靈活控制,,包括期望的長寬比,、空間引導(dǎo)信號(hào)等。

簡單來說,,MultiDiffusion的關(guān)鍵在于,在預(yù)先訓(xùn)練好的擴(kuò)散模型上定義一個(gè)全新的生成過程,。從噪聲圖像開始,,在每個(gè)生成步驟中,解決一個(gè)優(yōu)化任務(wù),。

然后再將多個(gè)擴(kuò)散生成過程與一組共享的參數(shù)或約束結(jié)合起來,,目標(biāo)是將每個(gè)部分都盡可能去接近去噪版本。

即便有時(shí)候每個(gè)步驟都可能會(huì)將圖像拉向不同的方向,,但最終融合到一個(gè)全局去噪步驟當(dāng)中,得到一個(gè)無縫圖像,。

來自魏茨曼科學(xué)研究所

這篇論文主要來自位于以色列雷霍沃特的魏茨曼科學(xué)研究所,。

兩位共同一作Omer Bar-Tal、Lior Yariv分別是魏茲曼科學(xué)研究院計(jì)算機(jī)科學(xué)和應(yīng)用數(shù)學(xué)系的研究生和博士生,,后兩位分別是他們的導(dǎo)師,。

△左:Omer Bar-Tal,;右:Lior Yariv

好了,,感興趣的旁友可戳下方試一試哦,!

https://huggingface.co/spaces/weizmannscience/MultiDiffusion

主頁鏈接:https://multidiffusion.github.io/

論文鏈接:https://arxiv.org/abs/2302.08113

文章出處:量子位